|

"

0

C

F

G

H

K

L

N

P

S

T

W

Z

А

Б

В

Г

Д

Е

Ж

З

И

Й

К

Л

М

Н

О

П

Р

С

Т

У

Ф

Х

Ц

Ч

Ш

Э

Ю

Я

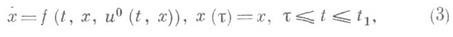

ОПТИМАЛЬНОЕ УПРАВЛЕНИЕ ПОЗИЦИОННОЕЗначение ОПТИМАЛЬНОЕ УПРАВЛЕНИЕ ПОЗИЦИОННОЕ в математической энциклопедии: - решение задачи оптимального управления математической теории, состоящей в синтезе оптимального управления в виде стратегии управления по принципу обратной связи, как функции текущего состояния (позиции) процесса (см. [1] - [3]). Последнее определяется, помимо текущего момента t, также доступными значениями текущих параметров. Таким образом, введение позиционной стратегии позволяет формировать реализаций) управления Uапостериорно, корректируя его на основе дополнительной информации, получаемой по ходу процесса. Простейшая задача синтеза, напр. для системы с ограничениями и. заданным "терминальным" показателем предполагает поиск решения и 0, минимизирующего функционал на минимум того же функционала и если функция u0(t, x).корректно определена, а уравнение имеет единственное решение, то задача синтеза решена, причем оптимальные значения показателя I, найденные в классах программных и позиционных управлений, совпадают (в общем случае выделяют условия, обеспечивающие существование в определенном содержательном смысле решений уравнения (3), и условия, гарантирующие оптимальность всех траекторий этого уравнения). Синтезированная функция u0(t, x), являющаяся О. у. п., позволяет построить оптимальное в смысле минимума функционала Iрешение задачи оптимального управления для любой исходной позиции Нахождение u0(t, x).сразу в виде функции текущего состояния связано с использованием метода динамического программирования (см. [2]). Вводимая в рассмотрение функция действия (функция Б е л л м а н a) V(t, х), имеющая смысл минимума (максимума) оптимизируемой величины (напр., функционала для системы (1) при x(t)=x:, - функция Гамильтона. Оно связано с уравнениями, фигурирующими в условиях Понтрягина принципа максимума, подобно тому, как уравнение Гамильтона - Якоби для функции действия связано в аналитич. механике с обыкновенным дифференциальным уравнением Гамильтона (см. Вариационные принципы классической механики). Вывод уравнения (5) для задачи синтеза опирается на принцип оптимальности, утверждающий, что отрезок оптимальной траектории есть снова оптимальная траектория (см. [2]). Правомерность такого подхода зависит от корректного определения информационных свойств процесса и, в частности, понятия позиции (текущего состояния, см. [5]). В задаче быстродействия - о минимальном времени Т(х).попадания траектории автономной системы (1) из положения хна множество М- функцию V(t, x)=V(x).можно рассматривать как своего рода потенциал V(x)=T(x).относительно множества М. Выбор оптимального управления u0(t, x).из условий (5), (6), приобретающих здесь вид тогда означает, что u0(t, х) = и 0 (х).осуществляет спуск оптимальной траектории х 0(t).относительно поверхностей уровня функции V(х).наискорейшим из способов, допускаемых условием Применение метода динамич. программирования (как достаточного условия оптимальности) будет обосновано, если функция V(t, x).всюду удовлетворяет определенным условиям гладкости (напр., в задаче (3)-(6) функция V(t, х).должна быть непрерывно дифференцируемой) или если условия гладкости выполняются всюду, за исключением нек-рого "особого" множества N. При выполнении нек-рых специальных "условий регулярного синтеза" метод динамич. программирования оказывается эквивалентным принципу Понтрягина, к-рый тогда выступает как необходимое и достаточное условие оптимальности (см. [8]). Трудности, связанные с априорной проверкой применимости метода динамич. программирования и с необходимостью решать дифференциальное уравнение Беллмана с частными производными, усложняют использование этого метода. Метод динамического программирования нашел распространение в задачах синтеза оптимального управления для дискретных (многошаговых) систем, где соответствующее уравнение Беллмана конечно-разностное (см. [2], [9]). В задачах оптимального управления с дифференциальными связями метод динамич. программирования дает эффективное решение задачи синтеза в замкнутой форме для класса задач, охватываемых линейными системами с квадратичным показателем (4) (функции f0, j суть положительно определенные квадратичные формы соответственно по х, и и по х). Эта задача об аналитическом конструировании оптимального регулятора при Решение задачи оптимальной стабилизации показало, что соответствующая функция Беллмана является в то же время "оптимальной" функцией Ляпунова для исходной системы с найденным оптимальным управлением. Отмеченные обстоятельства позволили получить эффективные условия стабилизируемости и построить для задач стабилизации полный аналог теории устойчивости по Ляпунову (по первому приближению и в критич. случаях), охватывающий обыкновенные квазилинейные и периодич. системы, а также системы с запаздыванием. В последнем случае роль функции Беллмана играют "оптимальные" функционалы Ляпунова - Красовского, заданные на отрезках траектории, соответствующих величине запаздывания в системе (см. [4], [5]). Теория линейно-квадратичных задач оптимального управления хорошо развита и для дифференциальных уравнений с частными производными (см. [11]). В прикладных задачах синтеза оптимального управления измерение всех фазовых координат системы доступно далеко не всегда. Поэтому возникает следующая задача наблюдения, допускающая многочисленные обобщения: зная на промежутке Свойство полной наблюдаемости, как и построение соответствующих аналитич. операций, выделяющих х(J), а также оптимизация этих операций хорошо изучены для линейных систем. Здесь известен принцип дуальности, состоящий в том, что каждой задаче наблюдения может быть поставлена в соответствие эквивалентная двухточечная краевая задача управления для дуальной системы. Вследствие этого оказывается, что свойство полной наблюдаемости линейной системы совпадает со свойством полной управляемости дуальной системы с управлением. Более того, оказывается, что и соответствующие дуальные экстремальные задачи об оптимальном наблюдении и оптимальном управлении могут быть составлены так, что их решения совпадут (см. [3]). Свойства управляемости и наблюдаемости линейных систем допускают весьма разнообразные обобщения на линейные бесконечномерные объекты (уравнения в банаховом пространстве, системы с отклоняющимся аргументом, дифференциальные уравнения с частными производными). Имеется и ряд результатов, характеризующих соответствующие свойства. Для нелинейных систем известен лишь ряд локальных теорем о наблюдаемости. Решения проблемы наблюдения нашли многочисленные применения в задачах синтеза в условиях неполной информации о координатах, в том числе в задачах оптимальной стабилизации (см. [3]-[5], [14], [15]). Задача синтеза становится особенно содержательной, когда информация об уравнениях управляемого процесса, исходных начальных условиях и текущих параметрах искажена возмущениями. Если описание возмущений носит статистич. характер, то задачи оптимального управления рассматривают в рамках теории стохастического оптимального управления. Эта теория, начатая с решения стохастических программных задач [10], в наибольшей степени разработана для систем вида со случайными возмущениями h(t), описываемыми гауссовскими диффузионными процессами или более общими классами марковских процессов (начальный вектор обычно также считают случайным). При этом, как правило, предполагается, что заданы нек-рые вероятностные характеристики величин h(напр., сведения о моментах соответствующих распределений или о параметрах стохастич, уравнений, описывающих эволюцию процесса h(t)). В общем случае применение программных и синтезирующих управлений здесь дает существенно различные значения оптимальных показателей J качества (роль таких показателей могут играть, напр., те или иные средние оценки неотрицательных функционалов, заданных на траекториях процесса). Задача синтеза стохастического оптимального управления теперь имеет очевидные преимущества, т. к. непрерывное измерение координат системы позволяет корректировать движение с учетом реального хода случайного процесса, непредсказуемого заранее. Здесь было обнаружено, что метод динамич. программирования совершенно естественным образом сопрягается с теорией бесконечно малых производящих операторов для полугрупп преобразований, генерируемый марковскими случайными процессами. Эти обстоятельства позволили построить и строго обосновать серию достаточных условий оптимальности, приведших к решению на конечном и бесконечном интервале времени ряда задач о синтезе стохастического оптимального управления с полной и неполной информацией о текущих координатах, стохастич. задач преследования и т. д. При этом существенно, что для справедливости принципа оптимальности управление и здесь должно строиться в каждый момент времени t как функция "достаточных координат" z процесса, для к-рых будет обеспечено свойство марковости (см. [5], [6], [17], [18]). Таким путем, в частности, была разработана теория оптимальной стохастической стабилизации, связанная с соответствующей теорией устойчивости по Ляпунову, развитой для сто-хастич. систем [19]. Для формирования синтезирующего оптимального управления, а также для иных целей управления целесообразно оценивать состояние стохастич. системы по результатам измерения. Решению этого вопроса при условии, что процесс измерения искажается вероятностными "шумами" (т. е. решению задачи наблюдения в условиях случайных возмущений), посвящена теория стохастической фильтрации. Наиболее полные решения здесь известны для линейных систем с квадратичными критериями оптимума (т. н. фильтр Калмана-Бьюси, см. [13]). В применении этой теории к задаче синтеза стохастического оптимального управления были выявлены условия, обеспечивающие справедливость принципа разделения, позволяющего решать собственно задачу управления независимо от задачи оценивания текущих позиции на основе достаточных координат процесса (см. [20]; более общим закономерностям стохастич. фильтрации, а также задачам стохастич. оптимального управления, когда само управление выбирается в классе марковских процессов диффузионного типа, посвящены работы [18], |21]). Строго формализованное решение задачи стохастического оптимального управления неизбежно соприкасается с проблемой корректного обоснования вопросов существования решений соответствующих стохастических дифференциальных уравнений. Последнее обстоятельство порождает определенные трудности в решении задач стохастического оптимального управления при наличии неклассич. ограничении. Содержательный процесс динамич. оптимизации возникает в задачах синтеза оптимального управления в условиях неопределенности (см. Оптимальное управление программное). Позиционные решения в общем случае позволяют и здесь улучшить показатели качества процесса по сравнению с программными, представляющими собой все-таки результат статич. оптимизации (проводимой, правда, в пространстве динамич. систем и функций-управлений). К решению задач тогда привлекают понятия и методы теории игр. Пусть имеется система на начальный вектор x0, управление ии возмущения w. В отличие от игрока-союзника, представляющего исходное управление и, подлежащее определению, воздействия w; здесь трактуют как управление игрока-противника и допускают к рассмотрению любые целенаправленные стратегии w, формируемые на основе любой допустимой информации. При этом цели управления могут быть сформулированы с точки зрения каждого из игроков в отдельности. Если названные цели противоположны, то возникает задача конфликтного управления. Исследование задач позиционного управления в условиях конфликта или неопределенности составляет предмет теории дифференциальных игр. Процесс формирования позиционного оптимального управления в условиях неопределенности может быть осложнен неполнотой информации о текущем состояний. Так, в системе (8) могут быть доступны лишь результаты косвенных измерений фазового вектора x -,; реализации y[t]функции где неопределенные параметры x стеснены известным априорным ограничением Наиболее полные решения здесь известны для линейных систем и выпуклых ограничений (см. [22]). В общем случае выбор позиционной стратегии оптимального управления в условиях неопределенности (напр., в виде функционала Если в задачах синтеза оптимального управления в условиях неопределенности трактовать параметры w,E как "управления" фиктивного игрока-противника, то цели управлений ии {w,x} могут быть различными. Последнее обстоятельство приводит к нескалярному показателю качества процесса, вследствие чего соответствующие задачи могут рассматриваться в рамках понятий о равновесных ситуациях, свойственных многокритериальным задачам теории неантагонистич. игр или их обобщениям. Лит.:[1] Понтрягин Л. С., Болтянский В. Г., Гамкрелидзе Р. В., Мищенко Е. Ф., Математическая теория оптимальных процессов, 3 изд., М., 1970; [2] Беллман Р., Динамическое программирование, пер. с англ., М., 1960; [3] Красовский Н. Н., Теория управления движением, М., 1968; [4] его же, "Дифференциальные уравнения", 1965, т. 1, №1, с. 5-16; [5] его же, в сб.: Механика в СССР за 50 лет, т. 1, М., 1968, с. 179-244; [6] его же, "Прикл. матем. и мех.", 1961, т. 25, № 5, с. 806-17; [7] Красовский Н. Н., Субботин А. И., Позиционные дифференциальные игры, М., 1974; [8] Болтянский В. Г., Математические методы оптимального управления, М., 1966; [9] его же, Оптимальное управление дискретными системами, М., 1973; [10] Летов А. М., Математическая теория процессов управления, М., 1981; [11] Лионc Ж., Оптимальное управление системами, описываемыми уравнениями с частными производными, пер. с франц., М., 1972; [12] Калман Р., в кн.: Труды 1 Международного конгресса Международной федерации по автоматическому управлению, т. 2, М., 1961, с. 521-47; [13] Калман Р., Бьюси Р., "Труды Амер. об-ва инженеров-механиков. Сер. 1, Д.", 1961, т. 83, с. 123; [14] Л и 3.-Б., Mapкус Л., Основы теории оптимального управления, пер. с англ., М., 1972; [15] Бутковский А. Г., Структурная теория распределенных систем, М., 1977; [16] Колмогоров А. Н., Мищенко Е. Ф., Понтрягин Л. С., "Докл. АН СССР", 1962, т. 145, № 5, с. 993-95; [17] Лиццер Р. Ш., Щиряев А. Н., Статистика случайных процессов, М., 1974; [18] Острем К. Ю., Введение в стохастическую теорию управления, пер. с англ, М., 1973; [19] Кац И. Я., Красовский Н. Н., "Прикл. матем. и мех.", 1960, т. 24, № 5, с. 809-23; [20] Wonham W. M., "SIAM J. Contr.", 1968, v. 6, p. 312-26; [21] Крылов Н. В., Управляемые процессы диффузионного типа, М., 1977; [22] КуржанскийА. <Б., Управление и наблюдение в условиях неопределенности, М., 1977; [23] Цыпкин Я. 3., Основы теории обучающихся систем, М., 1970; [24] Эйкхофф П., Основы идентификации систем управления, пер. с англ., М., 1975. А. Б, Куржанский. |

|

|

|

среди функций вида u(t, х).для произвольной исходной позиции

среди функций вида u(t, х).для произвольной исходной позиции  . Естественный путь состоит в решении для каждой позиции

. Естественный путь состоит в решении для каждой позиции  соответствующей задачи о построении оптимального управления программного

соответствующей задачи о построении оптимального управления программного

и при тех же самых ограничениях. Далее полагается, что

и при тех же самых ограничениях. Далее полагается, что

, в отличие от программного оптимального управления, зависящего, вообще говоря, от фиксированного начального состояния {t0, x0} процесса. Решение задачи оптимального управления в форме синтеза оптимального управления находит большие приложения, в частности в связи с тем, что реальные процедуры построения управления осуществляются, как правило, на фоне информационных помех или возмущений процедуры счета. В указанных ситуациях позиционное управление предпочтительней программного.

, в отличие от программного оптимального управления, зависящего, вообще говоря, от фиксированного начального состояния {t0, x0} процесса. Решение задачи оптимального управления в форме синтеза оптимального управления находит большие приложения, в частности в связи с тем, что реальные процедуры построения управления осуществляются, как правило, на фоне информационных помех или возмущений процедуры счета. В указанных ситуациях позиционное управление предпочтительней программного. (4)

(4) , должна удовлетворять дифференциальному уравнению Беллмана с частными производными и с краевыми условиями, зависящими от цели управления и показателя J. Для системы (1), (2), (4) это уравнение имеет вид

, должна удовлетворять дифференциальному уравнению Беллмана с частными производными и с краевыми условиями, зависящими от цели управления и показателя J. Для системы (1), (2), (4) это уравнение имеет вид  (5) где

(5) где  (6)

(6)

переходит в задачу об оптимальной стабилизации системы (из существования допустимого управления здесь сразу вытекает свойство асимптотич. устойчивости положения равновесия синтезированной системы) (см. [10], [4]). Существование решения в данном случае обеспечивается свойством стабилизируемости системы (см. [4]). Для линейных стационарных и периодич. систем оно эквивалентно свойству управляемости системы по неустойчивым собственным координатам (см. Оптимальное управление программное).

переходит в задачу об оптимальной стабилизации системы (из существования допустимого управления здесь сразу вытекает свойство асимптотич. устойчивости положения равновесия синтезированной системы) (см. [10], [4]). Существование решения в данном случае обеспечивается свойством стабилизируемости системы (см. [4]). Для линейных стационарных и периодич. систем оно эквивалентно свойству управляемости системы по неустойчивым собственным координатам (см. Оптимальное управление программное). реализацию

реализацию  доступной измерению функции y=g(t, х).координат системы (1) (при известном u(t), напр. при

доступной измерению функции y=g(t, х).координат системы (1) (при известном u(t), напр. при  , и

, и  ), найти вектор

), найти вектор  в заданный момент J. Системы, позволяющие по реализации y[t]однозначным образом восстанавливать

в заданный момент J. Системы, позволяющие по реализации y[t]однозначным образом восстанавливать  , каким бы он ни был, наз. вполне наблюдаемыми.

, каким бы он ни был, наз. вполне наблюдаемыми. (7)

(7) (8) при ограничениях

(8) при ограничениях

(9)

(9) . Знание y[t],

. Знание y[t], (при заданном u(t)), позволяет построить и фазовом пространстве информационную область

(при заданном u(t)), позволяет построить и фазовом пространстве информационную область  ) состояний системы (8), совместимых с реализацией у[t], уравнением (9) и ограничениями на w, x. Среди элементов

) состояний системы (8), совместимых с реализацией у[t], уравнением (9) и ограничениями на w, x. Среди элементов  будет содержаться и неизвестное истинное состояние системы (8), к-рое может быть оценено выбором нек-рой точки

будет содержаться и неизвестное истинное состояние системы (8), к-рое может быть оценено выбором нек-рой точки  из

из  (напр., "центра тяжести" или "чебышевского центра"

(напр., "центра тяжести" или "чебышевского центра" ). Изучение эволюции областей

). Изучение эволюции областей  и динамики векторов

и динамики векторов  составляет содержание теории минимаксной фильтрации.

составляет содержание теории минимаксной фильтрации. ) должен быть нацелен на управление эволюцией областей

) должен быть нацелен на управление эволюцией областей  (т. е. на изменение их конфигурации и перемещение их в пространстве) в соответствии с предписанными критериями. Для указанной задачи известен ряд общих качественных результатов, а также конструктивных решений в классе специальных линейно-выпуклых задач (см. [7], [22]). При этом информация, доставляемая измерениями (напр., функцией y[t] в системе (8), (9)), позволяет по ходу процесса апостериорным образом переоценивать области допустимых значений неопределенных параметров в направлении их сужения. Таким образом попутно решается задача идентификации математич. модели процесса (напр., параметров wуравнения (8)). Сказанное позволяет трактовать решения задачи о синтезе оптимального управления в условиях неопределенности как процедуру адаптивного оптимального управления, в к-ром уточнение свойств модели процесса переплетается с выбором управляющего воздействия как такового. Вопросы идентификации моделей динамич. процессов и задачи адаптивного оптимального управления подробно изучены в предположениях о существовании того или иного вероятностного описания неопределенных параметров (см. [23], [24]).

(т. е. на изменение их конфигурации и перемещение их в пространстве) в соответствии с предписанными критериями. Для указанной задачи известен ряд общих качественных результатов, а также конструктивных решений в классе специальных линейно-выпуклых задач (см. [7], [22]). При этом информация, доставляемая измерениями (напр., функцией y[t] в системе (8), (9)), позволяет по ходу процесса апостериорным образом переоценивать области допустимых значений неопределенных параметров в направлении их сужения. Таким образом попутно решается задача идентификации математич. модели процесса (напр., параметров wуравнения (8)). Сказанное позволяет трактовать решения задачи о синтезе оптимального управления в условиях неопределенности как процедуру адаптивного оптимального управления, в к-ром уточнение свойств модели процесса переплетается с выбором управляющего воздействия как такового. Вопросы идентификации моделей динамич. процессов и задачи адаптивного оптимального управления подробно изучены в предположениях о существовании того или иного вероятностного описания неопределенных параметров (см. [23], [24]).